vLLM 语义路由器:LLM 推理的新阶段

行业现状:推理并非越多越好

在过去的一年中,混合推理和自动路由已逐渐成为大模型基础设施进步的标志——业界争论的焦点已从原始规模转向单 token 效率、延迟控制和计算资源的定向使用。

以 GPT-5 为例:其突出的创新不在于参数的庞大规模,而在于其路由策略和基于配额的推理机制。

- 轻量级查询 → 轻量级路径:像“天空为什么是蓝色的?”这样的简单提问不会触发昂贵的推理过程。

- 复杂/高价值查询 → 启用推理功能的模型:像法律分析或财务规划这样的多步骤任务,会被路由到启用了“思维链”(Chain-of-Thought)的推理路径。

这代表了一种更广泛的原则,即“任务感知型计算资源分配”——推理过程中消耗的每一个 token 都必须贡献有意义的价值,而不仅仅是被消耗掉。

类似的想法也出现在其他系统中:

- Anthropic Claude 3.7/4:区分“快思”和“慢思”路径。

- Google Gemini 2.5:提供明确的*“思考预算”*,允许企业限制推理深度。

- 阿里巴巴 Qwen3:支持通过指令驱动在推理和非推理模式之间切换。

- DeepSeek v3.1:在单一双模模型中融合了对话流和推理流。

趋势很明显:未来的推理系统将由选择性和智能性来定义,而不仅仅是模型的大小。

近期研究:vLLM 语义路由器

为顺应这一转变,vLLM 语义路由器为高效的 vLLM 推理引擎提供了一个开源的、能够感知意图的路由层。

vLLM 能够实现可扩展的 LLM 服务,但缺乏围绕推理的语义决策能力。开发者面临一个权衡:

- 始终启用推理 → 准确率提高,但成本也随之增加。

- 禁用推理 → 成本降低,但在复杂任务上的准确率会受到影响。

语义路由器通过对查询进行语义分类并进行适当路由,填补了这一空白,从而在需要时提供准确的结果,在不需要推理时则保证了效率。

架构设计

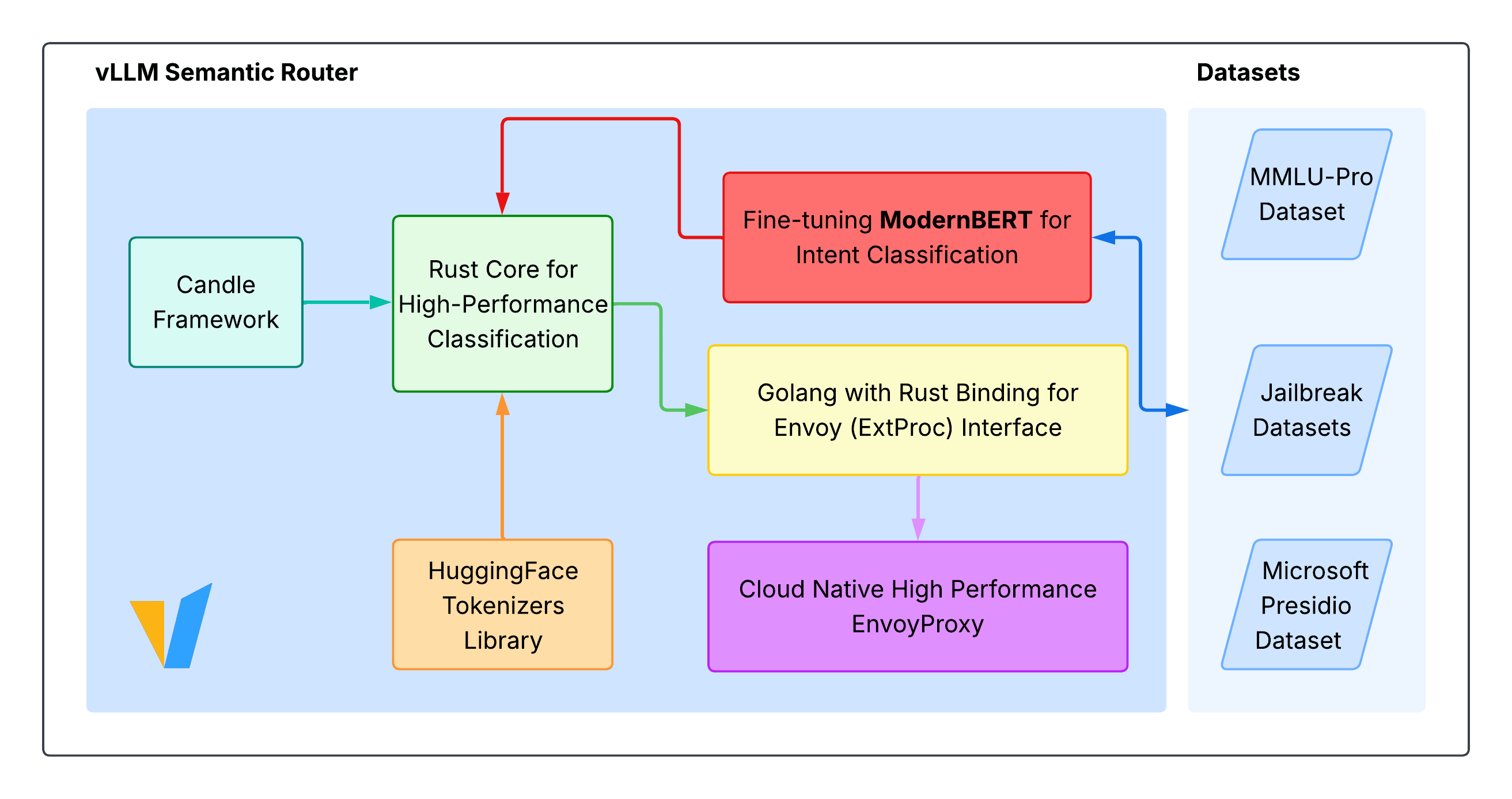

该系统包含四大支柱:

- 语义分类:使用 ModernBERT——目前是一个集成在路由器中的轻量级独立分类器——来决定路由路径。

- 智能路由

- 简单查询 → “快速路径”推理。

- 复杂查询 → “思维链”推理模式。

- 高性能引擎:使用 Hugging Face Candle 以 Rust 语言编写,可实现高并发和零拷贝推理。

- 云原生集成:通过

ext_proc插件,可与 Kubernetes 和 Envoy 实现开箱即用的集成。

在试验中,该设计实现了:

- 准确率提高约 10%

- 延迟降低约 50%

- token 数量减少约 50%

在商业和经济领域,准确率的提升超过了 20%。

执行中的挑战:预算与工具调用

有两个技术限制需要重点解决:

- 推理预算成本

无限制的推理会增加冷启动延迟和资源使用。如果没有动态控制,简单的查询可能会过度消耗 token,而关键查询在需要时可能无法获得深度推理。像 TTFT 和 p95 延迟这样的服务等级目标(SLO)是必要的——并且可能需要在推理过程中进行调整。 - 工具调用限制

增加更多工具(即“工具目录膨胀”)或更长的工具输出会大幅降低准确率。路由器必须对工具进行预过滤,并保持工具目录的精简。

项目背景

语义路由器源于整个开源社区的贡献:

- 由 陈华敏博士(红帽公司)于 2025 年初提出

- 由 刘寻卓(腾讯)进一步开发

- 将由 王晨博士(IBM 研究院)和陈华敏博士在 2025 年北美 KubeCon 上进行展示

我们的目标是:通过以下方式为开源 LLM 提供推理加速

- 语义感知路由

- 高效的模型切换

- 企业友好的部署(Kubernetes 和 Envoy)

你可以在 GitHub 上找到该项目。目前的重点是一个工作组和已规划的 v0.1 路线图。

集成与未来工作:嵌入模型与可插拔性

目前,ModernBERT 在路由器内部运行以进行分类,尚未由 vLLM 提供服务。然而,未来的工作目标是使分类器——以及其他可能的嵌入模型——变得可插拔,从而允许与 vLLM 托管的模型或外部嵌入服务集成。

这一能力将增强语义缓存,并使推理定制更加顺畅。

路线图:v0.1 里程碑亮点

v0.1 里程碑将扩展项目的技术能力:

- 核心:基于 ExtProc 的模块化、跨后端的语义缓存、多因素路由逻辑

- 基准测试:命令行界面(CLI)工具、性能测试套件、推理模式评估

- 网络:与 Envoy、GIE 和 llm-d 网关的更深度集成

- 可观测性与用户体验:管理仪表板、路由策略可视化、开发者快速入门指南和策略手册

未来趋势:即时推理

该领域正从“我们能否运行推理?”成熟到“如何让推理更智能?”

- GPT-5 利用商业价值来指导推理深度。

- vLLM 语义路由器将这种能力带给了开源社区。

展望未来,那些能够即时调整推理策略而无需手动切换的系统,将在效率、延迟和可持续性方面处于领先地位。

一句话总结

- GPT-5:面向企业的路由,实现更智能的推理

- vLLM 语义路由器:面向开源 LLM 的技术优先路由

- 边缘计算的未来:上下文感知、计算量最小且无缝工作的推理