vLLM 现已支持 Qwen3-Next:具有极致效率的混合架构

我们很高兴地宣布,vLLM 现已支持 Qwen3-Next,这是 Qwen 团队推出的最新一代基础模型。Qwen3-Next 引入了一种具有极致效率的混合架构以支持长上下文,vLLM 对其功能提供了全面支持。

在这篇文章中,我们将探讨 Qwen3-Next 的创新之处——混合注意力、高稀疏度 MoE 和多词元预测——并展示 vLLM 如何高效地支持它们。

快速入门

您可以通过 vLLM 夜间版(nightly)来运行 Qwen3-Next

uv pip install vllm --extra-index-url https://wheels.vllm.ai/nightly --torch-backend=auto

然后启动

vllm serve Qwen/Qwen3-Next-80B-A3B-Instruct -tp 4

请参阅 vLLM 模型实践指南,了解更详细的安装和使用说明。

混合注意力:高效的上下文建模

Qwen3-Next 的核心是其混合注意力设计,它用以下组合取代了标准注意力机制:

- 门控 DeltaNet(用于长上下文效率的线性注意力)

- 全注意力(用于高保真度推理的全注意力)

该模型在不同层之间交错使用这两种注意力形式,从而能够高效扩展到 65K 上下文长度甚至更长。

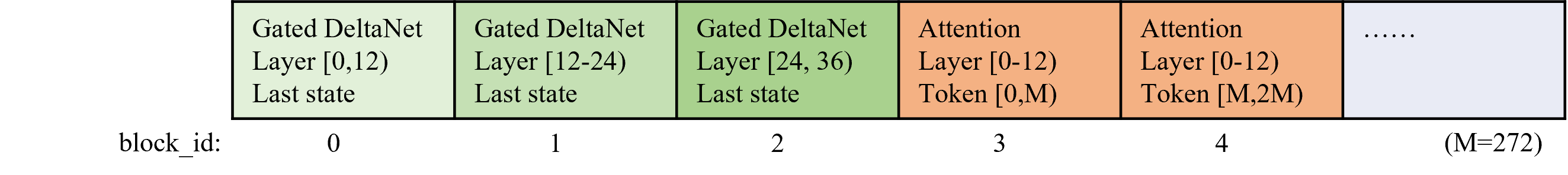

为了支持这一点,vLLM 集成了来自 Flash Linear Attention 的 Triton 内核,并采用混合 KV 缓存管理器来管理线性和全注意力层,避免了内存碎片化并最大化 GPU 利用率。

为了管理像 Qwen3-Next 这样的混合模型的状态,vLLM 自动调整全注意力层的“逻辑”块大小,以确保全注意力层和线性注意力层的状态占用相同数量的“物理”GPU 内存。这为混合模型实现了简单高效的分页内存管理,从而在 GPU 内存被完全利用时,提高了高负载工作下的吞吐量。

此外,Flash Linear Attention 基于 Triton。启动 Triton 内核可能会产生显著的 CPU 开销,这对仅解码批次的影响尤为严重。为了克服这个问题,vLLM 默认启用完整的 CUDA Graph 模式,确保在低延迟场景下也能有良好性能。

高稀疏度 MoE:极致效率

Qwen3-Next 通过激活率为 1:50 的 MoE 层进一步提升了稀疏度。在旗舰的 80B-A3B 模型中,每个词元(token)仅激活 3B 参数。借助内置的高效 MoE 实现,vLLM 能够实现出色的吞吐量和延迟。

多词元预测 (MTP)

Qwen3-Next 的另一项创新是多词元预测,它同时提升了预训练效率和推理速度。vLLM 原生支持此模式,使 Qwen3-Next 能够在不修改应用程序代码的情况下,每一步解码多个词元。请参阅实践指南以了解如何使用它。

展望未来

我们对 Qwen3-Next 的集成仅仅是个开始。我们的路线图包括:

- 进一步优化 GatedDeltaNet 层的内核。

- 更好的内存管理,以及为混合模型支持自动前缀缓存和 P/D 解耦。

- 持续提升吞吐量并降低 CPU 开销。

致谢

这项工作得以实现,得益于与众多合作伙伴的密切合作:

- Qwen 团队,包括 Tao He、Jianwei Zhang,感谢他们开源了该模型。

- Flash Linear Attention 团队,包括 Yu Zhang 等,感谢他们审查了门控 deltanet 注意力内核并改进了数值精度。

- NVIDIA,包括 Vadim Gimpelson,感谢他们测试了这些模型。

- IBM Research,包括 Thomas Parnell,感谢他在混合内存管理和 CUDA Graph 优化方面的工作。

- Red Hat,包括 Tyler Michael Smith、Doug Smith、Tarun Kumar 和 Elvir Crncevic,感谢他们测试模型并调整 MoE 内核。

- 社区合作伙伴:Meta、Roblox 等,感谢他们的测试、反馈和扩展性见解。

为这项工作做出贡献的 vLLM 团队成员包括:Jie Li、Kaichao You、Chen Zhang、Simon Mo。

👉 Qwen3-Next 现已在 vLLM 中可用。立即尝试,体验采用最新混合 MoE 架构的超高效长上下文推理。